OFF #14 | La newsletter para retomar el control

Enero 2024

¿Quieres conocer la hora de tu muerte?

Predecir y eliminar la incertidumbre. Este es uno de los principales propósitos del big data.

La cantidad de rastros que produce nuestra actividad digital (incluido cuando estamos aparentemente desconectados) es utilizada para alimentar modelos que tienen como objetivo anticipar toda clase de riesgos. Este principio puede aplicarse al clima, al crimen, a enfermedades, riesgos naturales, resultados académicos o deportivos, al divorcio, al rendimiento de un trabajador o al comportamiento de un consumidor, etc.

En esta primera edición de OFF de 2024, nos centramos en las cuestiones éticas que plantea aplicar este principio a asuntos humanos. ¿Es algo deseable? ¿Cuáles son sus consecuencias en términos de libertad individual y de justicia social? Exploramos cómo sería un mundo en el que la vida de las personas estuviera gobernada por la predicción de sus acciones futuras.

Principios y usos

La IA es capaz de detectar tendencias, patrones y asociaciones entre distintos fenómenos a partir de una multitud de datos, de una manera que supera al alcance de un cerebro humano. Así, mirando al pasado y al presente, trata de establecer probabilidades de que algo ocurra en el futuro.

Esto puede ser tremendamente útil cuando se aplica a la monitorización medioambiental, para predecir la probabilidad de que ocurra un incendio o la evolución de una epidemia, o para realizar el mantenimiento predictivo de aviones y sustituir las piezas que tienen una posibilidad de ser defectuosas.

Pero el big data también se puede explotar para anticipar el comportamiento humano y pretender eliminar los riesgos que puede conllevar. A grandes rasgos, se compara un individuo a partir de su actividad pasada con patrones similares y se pretende deducir probabilidades de que actúe como otras personas que comparten características o rasgos de comportamiento parecidos.

Conocer la hora de tu muerte

Hace unas semanas, un equipo de investigadores daneses y americanos dio a conocer Life2vec, una IA capaz de predecir las condiciones de la muerte de un individuo con una probabilidad del 78,8%. Para ello, analizaron los datos económicos, sociales y de salud de 100.000 personas de entre 37 y 67 años, de las cuales la mitad habían fallecido en los cuatro años siguientes. Estos datos alimentaron un algoritmo que tiene vocación de anticipar cuándo y cómo una persona va a morir en función de su perfil.

Esto podría resultar útil para prever los problemas de salud o establecer medidas para reducir la desigualdad que pueda afectar un grupo social pero también podría ser utilizado por una compañía de seguros para modificar su póliza, o por un banco para denegar un préstamo.

Los gigantes tecnológicos ya se interesan desde hace tiempo por este campo. Google también ha desarrollado un modelo a partir de datos de miles de pacientes para calcular la probabilidad de que uno salga vivo de un hospital cuando se le ingresa.

Solicitud rechazada

El big data también se explota para predecir riesgos aparentemente más triviales. Para el último fin de año, Airbnb puso en marcha una IA que analiza cientos de señales (no precisan cuáles) para detectar reservas asociadas con un alto riesgo de que los inquilinos monten una fiesta durante su estancia y rechazarlas automáticamente.

Imagínate estar intentando contratar un servicio y se te deniegue sin que sepas por qué. Técnicamente, sin una regulación adecuada, esto se podría aplicar en el sector financiero, por ejemplo para acordar o denegar una hipoteca. En lugar de basarse en criterios explícitos directamente relacionados con la situación financiera del cliente, la IA podría rastrear miles de datos sacados de su geolocalización, sus hábitos de compra o su salud, y de esta caja negra podrían sacar un veredicto, con todos los riesgos de discriminación y arbitrariedad que uno puede imaginar.

Prisioneros del pasado y de nuestros pares

Otro campo en el que la IA podría prescindir de un análisis humano es la justicia, por ejemplo para acordar o rechazar la libertad condicional a un preso en función de su probabilidad de reincidir. Ahí también, el método según el cual correlaciones estadísticas forman la base de una predicción podría generar toda clase de sesgos. Una renta baja, la pertenencia a una minoría o una serie de datos sin relación directa con los hechos a los que debería ceñirse una decisión podrían determinar una decisión.

Un mundo en el que estuviéramos encerrados en este tipo de modelo podría determinar nuestras vidas prácticamente desde el nacimiento. La abogada y autora de Datanomics, Paloma Llaneza, cita el ejemplo de un programa en un estudio en el Reino Unido en el que se establecería desde la temprana infancia si vale la pena o no invertir en la educación de un niño según su comportamiento. La base ideológica de este tipo de planteamiento atribuye una capacidad nula al individuo para evolucionar y liberarse de los patrones en los que se les enclaustra.

El riesgo de pretender eliminar el riesgo

Imagínate que estás jugando a un juego en el que te revelan desde el principio cuándo vas a perder. ¿Seguirías disfrutándolo o estaría tu mente acaparada por esta predicción? ¿Qué pasaría si un pronóstico sobre tu futuro fuera incorrecto y hubieses condicionado tu vida a esta creencia sin fundamento? ¿Actuaría esta como una profecía autocumplida o seguirías teniendo un margen para escapar a las estadísticas?

En un mundo en el que las decisiones sobre nuestro futuro individual se rigieran por patrones extraídos del big data, es posible que Einstein no hubiera conseguido una beca para el doctorado o una serie de genios no hubieran tenido segundas oportunidades antes de revelarse. La autoridad acordada a las predicciones podría condenar injustamente a personas por encajar en perfiles dibujados por una IA. Y la ausencia de libertad que atribuye a los individuos para trazar su propio destino sería a su vez destructora de libertad.

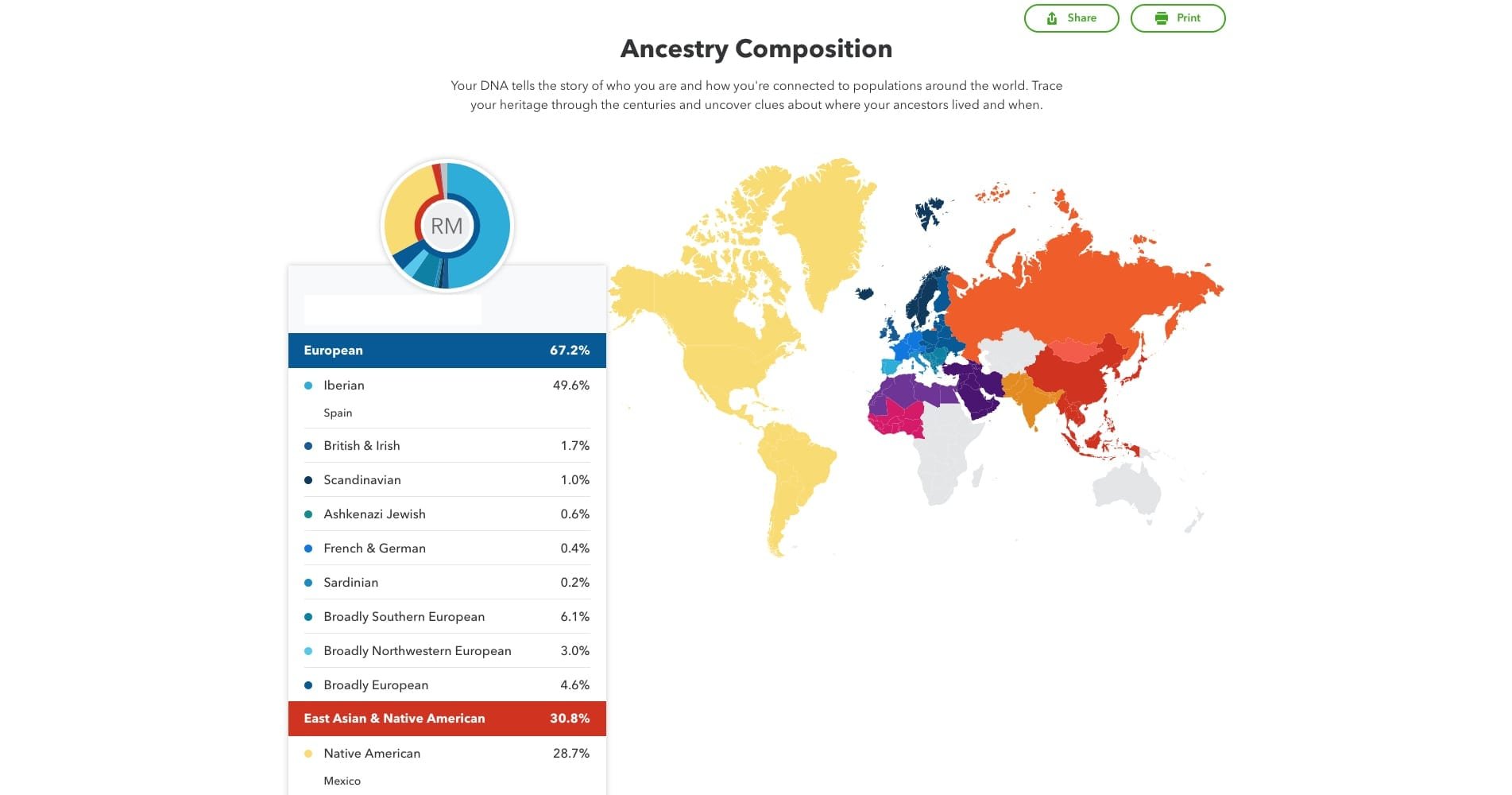

A menudo, el motor de estos modelos es nuestra propia curiosidad. En EE.UU. son cada vez más populares los test genéticos ofrecidos por compañías como Ancestry o 23andMe que revelan tu origen étnico y geográfico pero el coste de entregar en bandeja nuestra información genética podría ser mayor de lo que pensamos.

Mapa en el que el cliente de 23andme descubre sus orígenes según sus genes

Una pulsera conectada que registra nuestras constantes vitales y los pasos que marcamos podría ayudar a anticipar enfermedades pero permite identificarnos de una manera tan precisa como la de una huella dactilar y tal vez no nos compense.

Una eminencia médica me dijo un día que la medicina preventiva estaba muy bien, pero lo que peor sabía tratar la medicina era la ansiedad, que ella misma podía causar al darte a conocer tus futuros problemas. Tener la ilusión de conocer nuestro porvenir, considerarlo como una verdad probable, y permitir a terceros que hagan uso de esta información para orientar sus decisiones sobre nosotros podría no solo encerrarnos en este supuesto destino sino, paradójicamente, empeorar nuestras vidas.

Tal vez nos debamos reconocer que el riesgo es un componente esencial de la vida misma.

Suscríbete a OFF, la newsletter para retomar el control.

Una vez al mes, propongo una reflexión sobre una faceta específica de la influencia de la tecnología digital en nuestras vidas para ayudar a entender mejor la transformación acelerada de nuestro día a día.